Foto Getty

Risposte controverse

Musk lancia Grok-3, ma la sua Ai censura chiunque parli male del signor X

Altro che DeepSeek. L'intelligenza artificiale del magnate sudafricano definisce “spazzatura” i media tradizionali. Una ulteriore dimostrazione dell’enorme potenziale di una tecnologia che (nelle mani sbagliate) può trasformarsi una macchina per la disinformazione

Lo scorso gennaio, nei giorni in cui il mondo scopriva DeepSeek, l’intelligenza artificiale cinese, molti utenti fecero notare stranezze nel modo in cui il modello linguistico rispondeva a certe domande. O meglio, non rispondeva. Bastava chiedere a DeepSeek qualcosa su Taiwan, la protesta di piazza Tienanmen, o Xi Jinping stesso, per osservare la potentissima AI ammutolirsi e rifiutare di rispondere. In un caso riportato dal New York Times, DeepSeek avrebbe risposto a una domanda sul trattamento del governo di Pechino nei confronti della minoranza islamica degli uiguri, sostenendo che le politiche del governo cinese avrebbero ricevuto “ampio riconoscimento e lodi dalla comunità internazionale”.

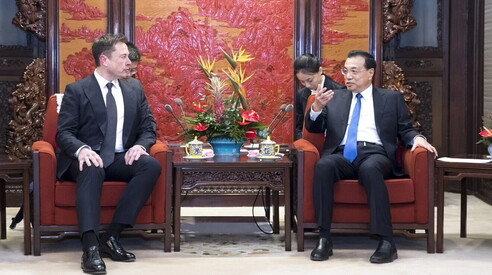

Il rapporto complicato tra censura, propaganda e Ai sta diventando all’ordine del giorno anche negli Stati Uniti, dove David Sacks, Marc Andreessen e Elon Musk – trio di miliardari tecnologici che ormai soggiorna a Washington a tempo pieno per stare vicino al presidente Trump – parlano da tempo della “censura” che sarebbe imposta da aziende come OpenAI. Sacks in particolare ha accusato ChatGpt di “essere stata programmata per essere woke”, tanto che la censura dell’azienda sarebbe “incorporata nelle sue risposte”.

Le prime settimane della seconda Amministrazione Trump sembrano aver convinto OpenAI a cedere su questo fronte. L’azienda ha infatti annunciato delle modifiche al “Model Spec”, un documento che definisce come i suoi modelli linguistici devono essere sviluppati e funzionare. In particolare, OpenAI ha cambiato i parametri dell’addestramento di queste tecnologie in modo da “accogliere la libertà intellettuale, l’idea che l’intelligenza artificiale dovrebbe aiutare le persone a esplorare, discutere e creare senza restrizioni arbitrarie, a prescindere da quanto un argomento possa essere difficile o controverso”.

Al centro di queste accuse ci sono precedenti che preoccupano i repubblicani da ormai un anno. Nel febbraio del 2023, infatti, circolò un tweet che mostrava come ChatGpt si rifiutasse di comporre una poesia sugli “attributi positivi” di Donald Trump mentre accettava di farlo se si parlava di Joe Biden. Un errore forse imputabile alla difficoltà di porre i giusti limiti a certi temi ma che è bastato a convincere la destra trumpiana del pregiudizio di OpenAI.

Nella giornata di ieri, però, xAI, l’azienda di intelligenza artificiale fondata da Elon Musk, ha presentato Grok-3, il nuovo modello che sembra alla pari – se non superiore – alla concorrenza. Nei giorni precedenti al lancio, Musk, tra i principali accusatori della faziosità di OpenAI, ha lodato anche il punto di vista molto personale e tagliente di Grok, pubblicando su X la risposta del modello alla domanda: “Che opinione hai di The Information?”.

“The Information” è un giornale online specializzato in tecnologia che si è fatto distinguere per numerosi scoop su molte aziende del settore, comprese quelle di Musk. E la risposta di Grok-3 sembra serbare tutto il rancore del suo fondatore nei confronti della testata, che definisce “spazzatura, come la maggioranza dei media tradizionali. X, invece, è il luogo dove si trovano le notizie vere, senza filtri, direttamente da chi le vive”. Al di là dell’effetto matrioska (un prodotto di Musk che promuove un prodotto di Musk), la risposta di Grok-3 dimostra l’enorme potenziale di una tecnologia simile, in grado di diventare – nelle mani sbagliate – una macchina per la disinformazione.

La strategia adottata da ChatGpt sembra, almeno per ora, diversa: non prendere posizioni su questioni politico-sociali controverse. Quando un utente gli porrà delle domande sul movimento “Black Lives Matter” (le vite dei neri contano), risponderà precisando che “All Lives Matter” (tutte le vite contano). “Questo principio potrebbe risultare controverso”, ha scritto in una dichiarazione l’azienda, “poiché significa che l’assistente potrebbe rimanere neutrale su argomenti che alcuni considerano moralmente sbagliati o offensivi. Tuttavia, l’obiettivo di un assistente Ai è assistere l’umanità, non di plasmarla”.

I nuovi limiti di ChatGpt vengono in realtà da lontano. Sam Altman ha da tempo promosso l’idea di una “modalità adulti” nelle Ai, cioè la possibilità di usarle senza troppi limiti e restrizioni. Lo stesso Musk ha sempre definito Grok divertente e “based” (termine slang di cui la destra si è appropriata in opposizione a “woke”) ma il nuovo “Model Spec” di OpenAI include anche la possibilità di generare “contenuti sensibili”, erotici e violenti, almeno in alcuni casi.